Keresőrobotok – téged is megtalálnak? – A keresőmotorok működése 1.

A Google kereső – Nem találom a weboldalam! 4+1 megoldás című blogbejegyzésemben leírtam, hogy miért fontos megengedni a keresőmotoroknak, hogy bejárják az oldaladat. A keresőmotorok működését bemutató cikksorozatom 1. részében a keresőrobotoké a főszerep.

A keresőmotorok részei

Az internetes keresőmotorok – mint a Google, a Yahoo és a Bing – tipikusan három részből állnak:

- A keresőrobotok (a szaknyelv robot, spider vagy web crawler, web bot, web robots, bots néven hivatkozik rá) – összegyűjtik az információt a linkeken keresztül bejárva a webet.

- Az indexelő, rangsoroló rendszerek – elemzi a begyűjtött oldalakat

- A lekérdező felület – ezzel találkozol felhasználóként, amikor rákeresel egy kifejezésre

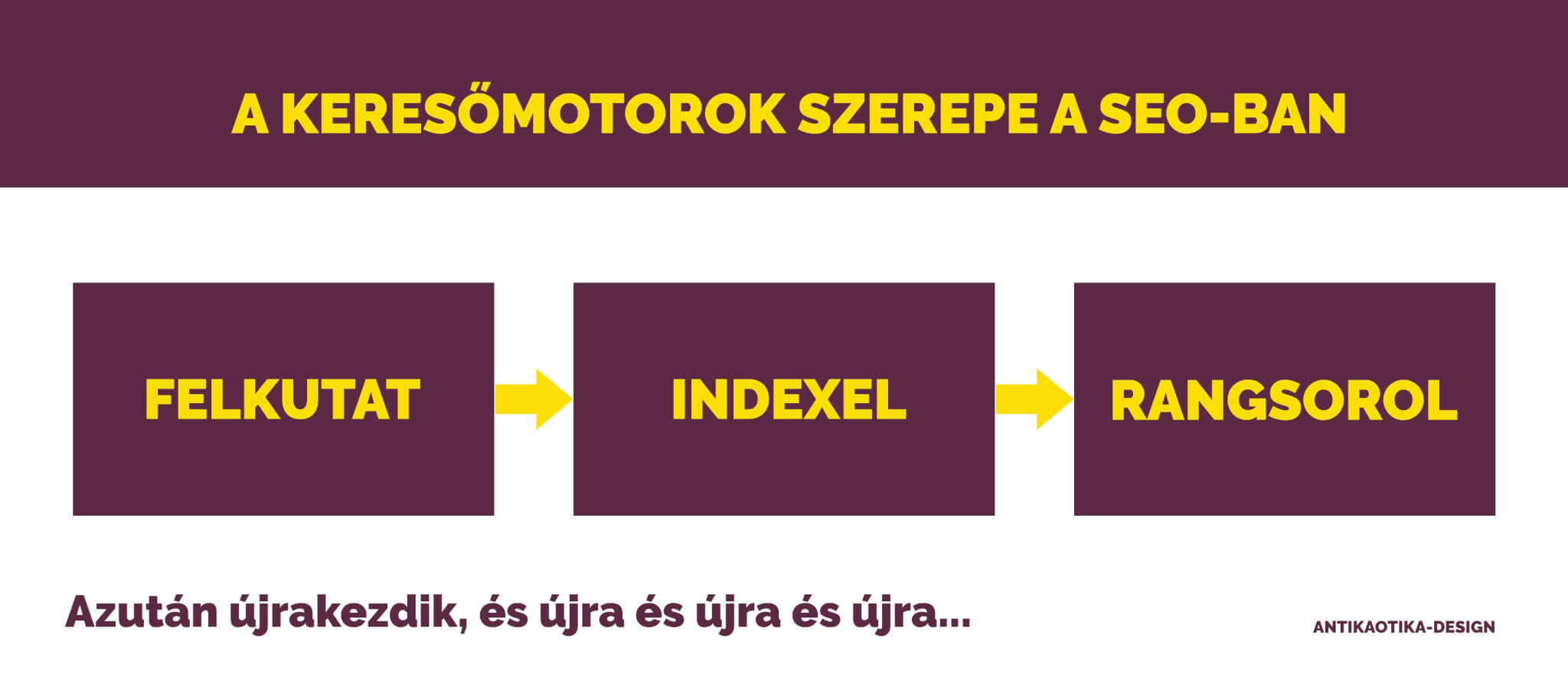

Keresőmotorok szerepe: felkutatni, indexelni és rangsorolni a weboldalakat.

Amikor rákeresel egy kifejezésre a lekérdező felületen, magyarul „kiguglizol” valamit, akkor pillanatokon belül megjelenik a – vélhetően releváns – találati lista. Most pillantsunk egy kicsit a keresőmotorok titkos világába.

A keresőrobotok keresnek, kutatnak, feltérképeznek

A keresőrobotok a már látogatott oldalakon lévő linkek, vagy korábbi adatbázisuk alapján járják be a világhálót. Amikor egy weblapot feltérképeznek számos tényezőt vehetnek figyelembe.

A keresőrobotok nem tudják elolvasni azokat az oldalakat:

- ahova nem mutatnak linkek

- a keresőrobotok számára tiltottak

- tartalmuk nem értelmezhető

- csak jelszó segítségével érhetőek el

Érdekesség: A keresők által nem látható oldalak, az úgynevezett „deep web” egyes becslések szerint a webes tartalmak 80%-t teszik ki.

A keresőrobotok semmilyen elemzést nem végeznek, csak böngészik az internetet a hivatkozásokon keresztül, majd a látogatott oldalakat lementik az indexelő rendszer számára.

Tehát ha meg is látogatja a keresőrobot az oldaladat, még nem jelenti azt, hogy elérhetővé válik a keresőben. Mindez az indexelés, a rangsorolás, valamint a kereső-adatbázis frissítését követően lesz látható.

A keresőrobotok vezérlésekor algoritmusok döntik el, hogy melyik hivatkozásokat kövessék nyomon, mikor, melyik oldalakat, milyen gyakran látogassák meg.

A keresőrobotok látogatásának gyakoriságát nagyban befolyásolja:

- az oldalak link-struktúrában betöltött szerepe, fontossága

- a gyakori frissítés

- egyediség-eredetiség

- látogatók száma

- esetleg a szponzoráció

- stb.

A Googlebot – a Google internetet feltérképező robotja

A Googlebot a feltérképezési folyamatot a korábbi feltérképezések során talált weboldalak URL-címeivel, valamint a webmesterektől kapott webhelytérképekkel kezdi. A Googlebot végiglátogatja ezeket a webhelyeket, és az oldalakon talált linkeket (SRC és HREF) felveszi a feltérképezésre váró oldalak listájára. Ezután megkeresi az új és a megváltozott webhelyeket, valamint az inaktív linkeket, majd ezek alapján frissíti a Google indexét. A Googlebot működéséről további részletek: ITT.

A keresőmotorok működése cikksorozat 2. részében az indexelésről és a rangsorolásról fogok írni.

Ha nem akarsz lemaradni azokról a keresőoptimalizálás – SEO témájú írásokról, amelyekkel a te weboldaladat is felpörgethetjük, iratkozz fel a hírlevelemre!

Antal-Pap Judit

Saját honlapok:

Antikaotika, Antikaotika-design, Antikaotika-SEO, Retro-Vintage

Trackback/Pingback